Podcasts

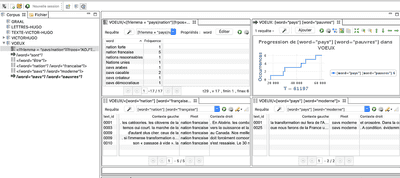

Iramuteq avec Renaud Debailly

Renaud Debailly (GEMASS) expose la façon dont Iramuteq (Interface de R pour les Analyses Multidimensionnelles de Textes et de Questionnaires) permet de cartographier un corpus préalablement défini et préparé pour l’analyse. Il précise la pertinence des différentes analyses possibles selon la taille du corpus produit et dans quels cas Iramuteq peut s’avérer pertinent pour une recherche. Il aborde ensuite la complémentarité de R et Python qui permettent d’effectuer des analyses de corpus ou de réseaux plus poussées. Enfin, Renaud Debailly décrit le type de restitution des résultats que propose…

Iramuteq avec Lisa Boltz

Lisa Bolz est chercheuse au GRIPIC, le laboratoire de recherche en sciences de l’information et de la communication du CELSA à Sorbonne Université. Ses thématiques de recherche concernent les formes et écritures médiatiques et l’histoire de la presse. Elle travaille sur les nouvelles formes de journalisme sur les nouvelles plateformes en ligne. Lisa Bolz nous parle de son expérience avec le logiciel libre Iramuteq (Interface de R pour les Analyses Multidimensionnelles de Textes et de Questionnaires) lors de ses recherches doctorales sur les dépêches d’agence au XIXème siècle. Après avoir…

Iramuteq avec Adeline Wrona

Dans ce podcast, Adeline Wrona (GRIPIC) nous présente comment les méthodes numériques permettent d’explorer les corpus massifs offerts par la numérisation de la presse française du XIXème siècle. Elle nous parle de la manière dont les méthodes numériques ont été investies dans le programme de recherche GIRANIUM. Par exemple, à travers l’utilisation du logiciel R, il a été possible de mettre en exergue la “viralité” de l’écriture médiatique dans le corpus de textes constitué autour d’Emile de Girardin (sa correspondance intime ainsi que l’ensemble des journaux qu’il a créé). Cela offre l…

RGPD et sciences sociales

Un podcast avec Julien Rossi, anciennement UTC/COSTECH, désormais Paris 8/CEMTI. Voir également l’atelier PGD, RGPD, archivage des données personnelles dans les SHS, qui a eu lieu le 19 novembre 2021, ainsi que le détail des réponses aux questions posées lors de cet atelier.

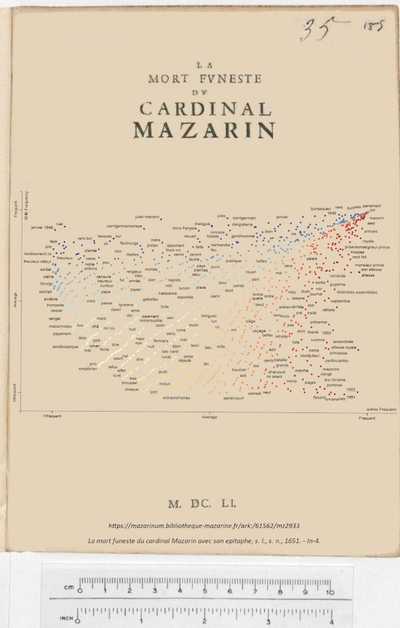

Antonomaz - Visualisation de sources multiples

Alexandre Bartz est ingénieur sur le projet Antonomaz, diplômé d’un cursus d’Histoire et du master “Technologies numériques appliquées à l’Histoire” de l’Ecole des Chartes. Vous pouvez compléter l’écoute de ce podcast en consultant les ressources évoquées par Alexandre : Le projet Antonomaz sur GitHub Pour la visualisation : Kibana R (langage) Pour le nettoyage des données : Dataiku Crédits : Interview : Emmanuelle Papinot et Thibault Grison Générique et habillage sonore : Thomas Bottini et Virginie Julliard Prise de son : Thibault Grison Montage : Marie-Angélique Mennecier.

Extraction de données sur Instagram

Marine Buffard (GRIPIC / SCAI) effectue une thèse sur “L’intelligence artificielle au prisme d’Instagram” et plus spécifiquement sur l’impact de cette médiation sur les représentations du yoga. Elle commente les différents modes de collectes de données qu’elle réalise, notamment avec Python, ainsi que les contraintes et les difficultés qu’elle rencontre. Elle conclut sur son analyse des images qui lui permet de constater un changement significatif dans la pratique du yoga.

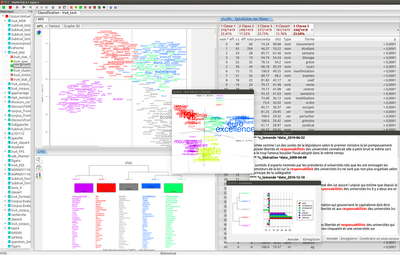

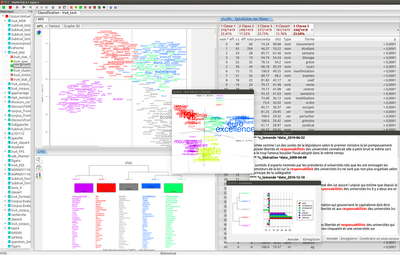

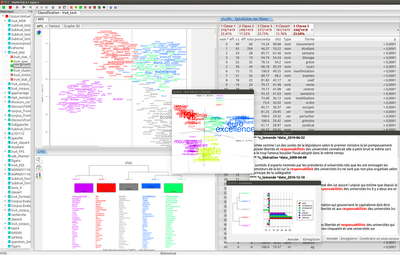

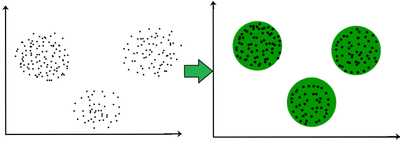

Méthodes de clustering

Solveig Poder & Carlos González Gallardo présentent le principe des méthodes de clustering qui permettent de regrouper des données non étiquetées afin de les traiter et de les interpréter. En les mobilisant sur trois corpus différents dont deux relatifs aux projets Ceres (Sackler et PMA), ils décrivent la façon dont ils ont rendu ces méthodes accessibles aux chercheurs en SHS à travers le développement d’une interface de visualisation des données. Crédits : Interview : Emmanuelle Papinot Générique et habillage sonore : Thomas Bottini et Virginie Julliard Prise de son : Thibault Grison Montage…

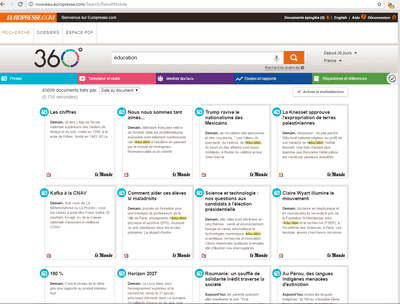

Europresse avec Gaël Lejeune

Gaël Lejeune (STIH) expose la façon dont Europresse permet de collecter des corpus d’articles de presse pouvant faire l’objet d’analyses automatisées par la suite. Il évoque également les limites de cette base de données tout en discutant des méthodes de collecte et d’analyse des corpus de presse qui font notamment surgir une problématique autour des formats des données de la recherche. Gaël Lejeune explicite enfin son processus de développement d’un outil d’automatisation de collecte de corpus à partir d’Europresse, aujourd’hui mis à disposition des chercheurs par l’unité de service CERES.

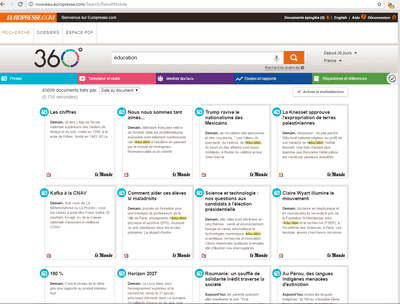

Europresse avec Thibault Grison

Thibault Grison (SCAI, GRIPIC) présente un cas d’usage d’Europresse dans son mémoire de recherche en SHS sur la défense de la “liberté d’expression” dans la presse française. Il explique comment il est parvenu à constituer un corpus multi-sources de plusieurs centaines d’articles, tout en présentant les difficultés auxquelles il a été confronté dans cette collecte. Il évoque enfin Factiva, une autre base de presse en ligne.